¿Puede la inteligencia artificial traducir el lenguaje de las plantas?

Este viaje nos invita a considerar nuevas formas de coexistencia y comunicación en nuestro planeta, viendo a las plantas no solo como seres vivos, sino como entidades con las que podríamos, algún día, dialogar con ayuda de IA.

¡Hola! Antes de comenzar a disfrutar de una deliciosa aguapanela con arepa y sumergirte en el sinfín de posibilidades que ofrecen las herramientas de LLM, me gustaría presentarme adecuadamente. Conocer quién soy te permitirá adentrarte en la red neuronal de conceptos y preguntas que forman mi pensamiento diario.

Me llamo Lina, y soy Ingeniera de las Artes Digitales, apasionada y admiradora incansable de todos los campos quiméricos relacionados con el diseño.

Toma en cuenta que mis preguntas a menudo requieren la interpretación de un asesor personal para desentrañar un concepto desconocido y explorar nuevas posibilidades mientras aprendo. Por eso, en esta ocasión, mi editorial tecnológica y visionaria para mi guión es GPT.

Ahora sí 🤓, empecemos:

¿Cómo se Origina la Pregunta?

Durante años, he reflexionado sobre los patrones de diseño, los procesos y el lenguaje inherente a la naturaleza. Desde que comenzó a popularizarse la inteligencia artificial, comprender a fondo estas herramientas ha sido un reto, tanto como lo es entender nuestra propia lengua y su compleja estructura de variables que la definen.

En cierto momento, me di cuenta de que comprender un idioma también implica una interpretación personal y una conexión directa con el objeto de estudio. No es suficiente con un diccionario para captar la esencia de un abrazo de mi padre comparado con el de un desconocido, o entender una disculpa transmitida solo con la mirada; se necesita tiempo y un extenso análisis para incluso empezar a entender el lenguaje de un solo individuo. No obstante, considerando que LLMs como GPT han potenciado mi capacidad de análisis de datos (o quizás han sobrecargado mi memoria), me surgió la curiosidad: ¿sería factible que, mediante mis interpretaciones personales de gestos, signos, mensajes, emociones y significados, pudiera algún día crear un traductor personal de lenguajes no humanos, como el de las plantas?

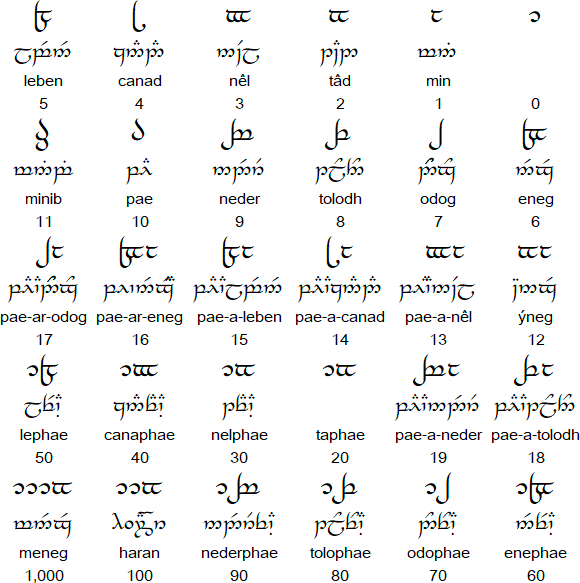

Resultados personales de un laboratorio de producción gráfica que utilizó tecnologías informáticas (redes neuronales) y se nutrió del intercambio de conocimiento entre la biología, la ecología, la taxonomía y la tipografía.

¿Qué es una LLM?

Una LLM (Language Learning Model), o Modelo de Aprendizaje de Lenguaje, es una forma avanzada de inteligencia artificial. Está fundamentada en una red neuronal compleja que se alimenta de enormes conjuntos de datos. Esta red es capaz de identificar patrones y establecer conexiones entre vastas cantidades de texto, lo que le permite analizar y comprender el lenguaje con una profundidad similar a la del análisis lingüístico humano en distintos niveles.

La eficacia de una LLM depende de la riqueza y diversidad de su conjunto de datos. Cuanto más extenso y variado sea este dataset, más afinada y precisa será su habilidad para generar respuestas coherentes y contextuales. Interactuar con una LLM puede considerarse casi un arte. El 'prompt' o instrucción que se proporciona actúa como un director, donde la elección precisa de palabras, la estructura de la oración y la inclusión de ejemplos específicos pueden influir notablemente en la calidad de la respuesta generada.

A pesar de ello, el resultado de una LLM puede ser impredecible, reflejando la complejidad del lenguaje y de la interpretación humana. Aunque se basa en una extensa base de datos y está diseñada para emular los procesos humanos de comprensión y creación de lenguaje, el resultado puede variar según la exactitud del 'prompt' y la interpretación única que el modelo haga de él. Esta dinámica entre un input meticulosamente elaborado y la interpretación avanzada de la LLM marca la frontera de lo que hoy es posible en la tecnología del lenguaje y la comunicación humana.

¿Qué es el lenguaje?

El lenguaje es un sistema intrincadamente complejo que facilita la comunicación y el intercambio de información entre seres. Funciona como una herramienta imprescindible para la expresión de pensamientos, la interacción social y la transmisión de la cultura y el conocimiento de generación en generación. Incluye aspectos cruciales como:

- Símbolos o signos a los cuales se les asigna significado.

- Una estructura interna que organiza estos símbolos para transmitir mensajes más complejos.

- La capacidad de formar infinitas combinaciones y oraciones.

- Variaciones según los contextos culturales y sociales, afectando aspectos como la pronunciación o el léxico.

- Una función que trasciende la mera comunicación, ya que también sirve para expresar emociones, establecer conexiones visuales o sociales, y más.

¿Puede una LLM interpretar una lengua muerta basándose en pictogramas?

Una LLM puede ofrecer interpretaciones y apoyar el análisis de lenguas muertas que utilizan pictogramas, pero su efectividad dependerá en gran medida de la disponibilidad y calidad de los datos de entrenamiento. Por ejemplo:

- Si los datos disponibles de una lengua muerta son escasos, la capacidad de la LLM para interpretar correctamente será proporcionalmente limitada.

- Las lenguas basadas en pictogramas a menudo requieren una comprensión contextual profunda del entorno cultural, histórico y social en el que se utilizaron. Las LLMs pueden no tener esta comprensión sin una investigación complementaria.

- Los pictogramas pueden ser intrínsecamente ambiguos y sujetos a múltiples interpretaciones. Sin el contexto cultural pertinente, puede ser un desafío para una LLM asignar la interpretación adecuada.

- La interpretación acertada de lenguas antiguas frecuentemente necesita un enfoque multidisciplinario que involucre especialistas en lingüística, historia, arqueología, entre otros. Aunque una LLM puede sugerir hipótesis o traducciones basadas en patrones y correlaciones lingüísticas, la validación de expertos humanos es indispensable.

- La habilidad de las LLMs para interpretar lenguas muertas podría mejorar con aprendizaje continuo y feedback. No obstante, este proceso necesita datos fiables y una supervisión meticulosa.

La falta de un entrenamiento profundo y exhaustivo en las LLM, especialmente en lo que respecta a datos con contexto cultural, puede llevar a malinterpretaciones significativas de nuestras consultas, destacando la importancia de enriquecer estas herramientas con datos diversificados que reflejen la complejidad humana. Sin embargo, la creatividad humana y la búsqueda de nuevos métodos de comunicación abren un abanico de posibilidades para la innovación colaborativa entre humanos y máquinas. Al combinar nuestras capacidades creativas con la potencia de las LLM, tenemos la oportunidad no solo de trascender las barreras lingüísticas actuales, sino también de forjar nuevos lenguajes que capturen con mayor fidelidad la esencia de nuestra realidad y aspiraciones, marcando el camino hacia futuros comunicacionales que hoy apenas podemos imaginar.

¿Es posible que un humano, con ayuda de una LLM, pueda crear una nueva lengua y una LLM a partir de ella?

Crear una nueva lengua con la ayuda de una LLM es factible, aunque enfrentaría múltiples desafíos y requeriría una serie de etapas meticulosas. La adopción y el uso práctico por una comunidad son pasos cruciales que llevarían el modelo de la teoría a la práctica, lo cual trasciende la simple construcción de un modelo de inteligencia artificial:

- Inicialmente, tendríamos que establecer las reglas gramaticales, el léxico y la sintaxis de la nueva lengua. Basándonos en esta estructura fundamental, la LLM podría asistirnos en la generación de un conjunto básico de datos y, eventualmente, en la creación de una LLM más avanzada.

- La interacción continua con la LLM sería esencial para perfeccionar y ajustar la generación lingüística conforme a la estructura propuesta.

- Sería necesario recopilar todos los textos generados para formar un conjunto de datos para el entrenamiento de una LLM más sofisticada. Esto, sin mencionar la necesidad de una infraestructura computacional potente para el proceso de entrenamiento.

- Habría que someter a la LLM a diversas pruebas para confirmar su comprensión de la nueva lengua y, basándonos en los resultados, realizar ajustes continuos para optimizar su rendimiento.

- Por último, y quizás lo más importante, requeriríamos de una comunidad dispuesta a adoptar y evolucionar la nueva lengua, lo cual podría dar lugar a nuevas formas y transformaciones del idioma, así como a nuevos objetos de estudio.

La existencia de comunidades que se comunican mediante métodos aún no completamente comprendidos por nosotros plantea un desafío intrigante, impulsando la necesidad de enfoques holísticos y multidisciplinarios en lingüística e inteligencia artificial. Esto nos lleva a explorar no solo la estructura y sintaxis tradicionales, sino también los contextos culturales, sociales y emocionales que enmarcan la comunicación. El desarrollo de Modelos de Lenguaje de Aprendizaje (LLM) que puedan procesar y interpretar no solo el lenguaje verbal, sino también las sutilezas no verbales, requiere de una colaboración interdisciplinaria entre lingüistas, sociólogos, antropólogos, ingenieros de IA y las propias comunidades. Este esfuerzo conjunto no solo enriquecerá nuestra comprensión de la diversidad lingüística humana, sino que también fomentará la creación de tecnologías de IA que celebren y respeten esta diversidad, mejorando nuestra capacidad para comunicarnos y conectarnos de manera más efectiva.

¿Es posible que la inteligencia artificial pueda traducir el lenguaje de las plantas?

Explorar la capacidad de la inteligencia artificial para traducir el lenguaje de las plantas abre una ventana a posibilidades teóricas fascinantes, aunque se enfrenta a múltiples desafíos que merecen un análisis detallado:

- Comunicación de las Plantas: Si bien las plantas no disponen de un lenguaje en el sentido convencional humano, sí participan en complejas interacciones mediante señales químicas, eléctricas y a través de sus raíces y fitohormonas. Establecer entornos experimentales que nos permitan comprender cómo las plantas reaccionan a su entorno podría ofrecernos la base para "interpretar" estas respuestas como una forma de comunicación.

- Interpretación Subjetiva: La interpretación de la comunicación de las plantas podría variar significativamente entre investigadores, presentando un modelo abstracto de comunicación. Esto se debe a que las señales químicas y los cambios en el crecimiento podrían interpretarse de manera subjetiva, considerando factores como las emociones o visiones del mundo individuales. La necesidad de colaboración interdisciplinaria es imperativa, involucrando a botánicos, ecólogos, bioquímicos y expertos en ciencia de datos para abordar estas interpretaciones.

- Desarrollo de un Corpus de Datos: La creación de una LLM que pueda interpretar el lenguaje de las plantas requeriría un extenso corpus de datos. Esto implicaría recopilar observaciones detalladas y mediciones de las interacciones de las plantas con su entorno, asegurando la consistencia y fiabilidad de los datos para representar adecuadamente la diversidad de comunicaciones de las plantas.

- Retos en el Entrenamiento de la LLM: Entrenar una LLM para esta tarea es particularmente desafiante, ya que el "lenguaje" de las plantas no posee gramática, sintaxis ni semántica en el sentido humano. Sería necesario desarrollar enfoques innovadores para modelar un tipo de comunicación que es fundamentalmente diferente de las formas humanas de intercambio lingüístico.

En conjunto, aunque la idea de utilizar la inteligencia artificial para descifrar el lenguaje de las plantas presenta retos considerables, también ofrece un potencial extraordinario para profundizar nuestra comprensión de las comunicaciones no humanas y fortalecer nuestra conexión con el mundo natural.

Conclusiones

En conclusión, la idea de emplear una LLM para interpretar la comunicación de las plantas, una forma de interacción no humana tan compleja, es sin duda fascinante y promete abrir caminos hacia nuevas comprensiones de cómo las plantas interactúan con su entorno. Sin embargo, enfrentamos desafíos significativos que trascienden las capacidades actuales de la tecnología y requieren una colaboración extensa y multidisciplinaria. Además, la interpretación de estas comunicaciones plantearía la necesidad de un enfoque altamente personalizado, donde la perspectiva única del investigador influiría profundamente en la "traducción". Tal traductor no sería universal, sino más bien una herramienta personalizada, ajustada a las interpretaciones individuales y sujetas a variables innumerables y profundamente humanas como la cultura, las creencias, los métodos de investigación, el ambiente, la experiencia personal y los marcos espirituales, entre otros.

Aunque la tarea de traducir lenguajes completamente ajenos a nuestra experiencia humana directa permanece en el horizonte, ya disponemos de herramientas de LLM en español que nos asisten en la exploración de preguntas filosóficas diarias y en la optimización de procesos de datos. Estas herramientas representan un paso hacia la comprensión más profunda de nuestras propias capacidades lingüísticas y cognitivas, así como un avance en nuestra relación con el mundo natural y las otras formas de vida con las que compartimos nuestro planeta.

- GPT-4 de OpenAI: Es la última iteración de la IA generativa de OpenAI y cuenta con la capacidad de procesar imágenes y videos, aunque solo puede generar respuestas en formato de texto.

BARDGemini de Google: Un chatbot de LLM que puede generar texto, traducir varios idiomas, crear código, y generar contenido variado. También puede acceder a datos del mundo real a través de Google Search.- LlaMa 2 de Meta AI: Un modelo de lenguaje grande de código abierto que está optimizado para plataformas como AWS, Azure y la plataforma de alojamiento de modelos de IA de Hugging Face.

- BLOOM: Un LLM de código abierto con capacidades multilingües en 46 idiomas y 13 lenguajes de programación, disponible a través de la plataforma Hugging Face.

- MPT-7B de MosaicML Foundations: Un modelo de transformador de solo decodificador de estilo GPT que cuenta con licencia para uso comercial.

- Falcon LLM: Un modelo de código abierto que destaca por su gran número de parámetros y es accesible al público general.

- Claude de Anthropic: Ofrece dos versiones, Claude para alto rendimiento y Claude Instant, más rápido y económico. Claude 2 presenta mejoras en codificación y razonamiento matemático.

- GPT-3.5 de OpenAI: A pesar de ser el predecesor de GPT-4, sigue siendo uno de los LLMs más formidables y es gratuito con ChatGPT.

- Amazon Q: Un producto de IA generativa diseñado específicamente para uso empresarial, entrenado con 17 años de experiencia de AWS.

Temas/tags del artículo:

LLM, AI, Lengua, Lenguaje, Planta, Filosofando.

Te dejo algunos artículos de referencia: